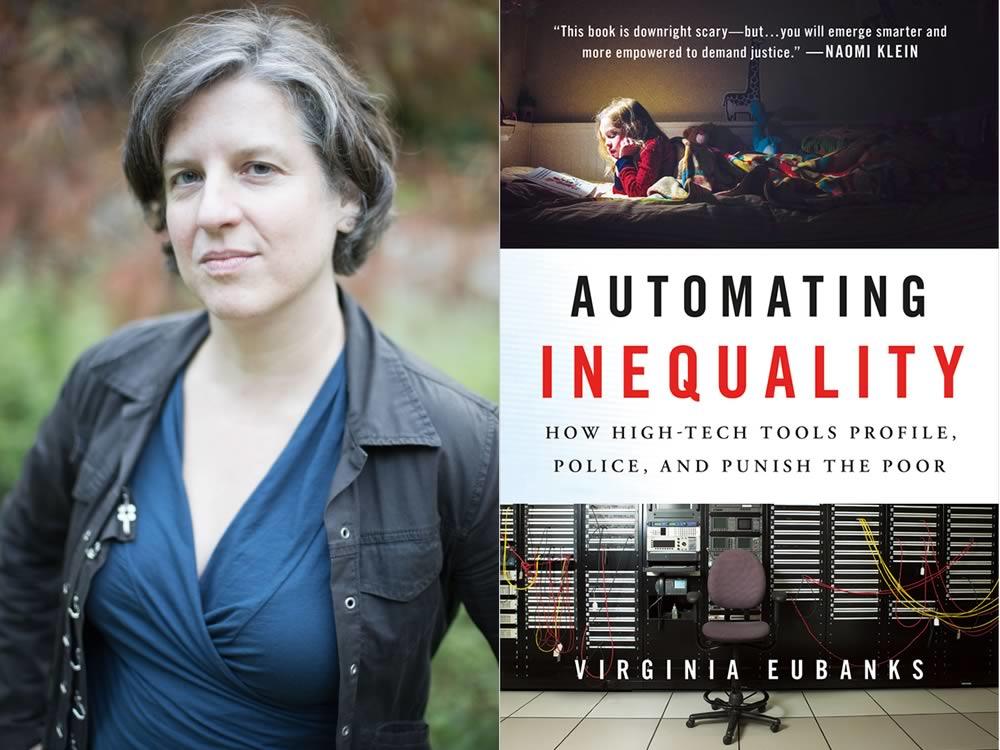

Como os algoritmos, construídos por seres humanos, podem intensificar desigualdades? Em 2018, dois livros foram destaque nesse assunto. Um é Algorithms of Oppression, de Safiya Noble, sobre como os mecanismos de busca reforçam o racismo. Outro é Automating Inequality, de Virginia Eubanks. Como a automatização e o uso de algoritmos nos serviços públicos tem reforçado e acelerado desigualdades, com a vigilância e o perfilamento dos pobres?

Segundo Eubanks, a automatização dos serviços públicos começou nos anos 1960 nos Estados Unidos e intensificou-se nos últimos anos, criando uma aura de eficiência, objetividade e infalibilidade. Mas, na verdade, isso estaria criando uma versão digital das poorhouses no país, punindo as pessoas por serem pobres.

Quais os valores e crenças embutidos nos algoritmos? Como isso tem reforçado as desigualdades? Como confrontar essas lógicas? Eubanks, que é professora de Ciência Política da State University of New York, em Albânia, conversou com a DigiLabour sobre esses assuntos presentes em Automating Inequality.

DIGILABOUR: O que você chama de digital poorhouse?

VIRGINIA EUBANKS: Eu começo meu livro falando sobre desigualdade em um momento histórico bem específico, porque, frequentemente, quando falamos sobre essas novas ferramentas tecnológicas, falamos sobre elas como se fossem “disruptivas”. Como se fossem novas em folha e nós nunca tivéssemos visto nada igual antes. Mas, especificamente quando você olha para a maneira como essas ferramentas foram utilizadas em programas de serviço público e de assistência alimentícia dos Estados Unidos, saúde pública, esses tipos de coisa, nós vemos que essas ferramentas são muito mais casos de evolução do que de revolução. Então, eu me refiro a essas ferramentas como se elas tivessem criado as poorhouses digitais, pois isso as localiza nessa história dos Estados Unidos, que basicamente começa com a criação do que eram conhecidas como poorhouses do condado. Elas são criadas nos anos 1800, quando há uma enorme crise econômica nos Estados Unidos. E os líderes econômicos da época decidiram que o jeito de lidar com isso, incluindo pobreza e desigualdade econômica, seria construindo instituições físicas, de tijolo e concreto, onde pessoas pobres e trabalhadoras poderiam, basicamente, ser encarceradas se elas não tivessem recursos suficientes para se manterem. E é um momento bem importante na História dos EUA, pois é o momento em que decidimos, como uma comunidade política, que a primeira e mais importante coisa que nosso Sistema de Serviços Públicos deveria fazer é decidir, moralmente, se as pessoas seriam ou não dignas de assistência. Então, as poorhouses rurais deveriam fazer isso, era esperado delas que fizessem as condições para receber ajuda tão terríveis, que ninguém senão as pessoas mais absolutamente desesperadas pediam e eram aceitas para integrar a poorhouse. E eu argumentaria que a maneira como essas novas ferramentas que vemos na Assistência Pública, como bots desempenhando trabalhos de estatística e tomadas de decisões baseadas em inteligência artificial e aprendizado de máquina, funcionam de maneira praticamente igual, que é traçando potenciais comportamentos futuros das pessoas, policiando suas moralidades e despesas, e punindo pessoas que pedem por ajuda. Por isso, chamo isso de poorhouse digital.

DIGILABOUR: Como a automatização dos serviços públicos contribui para a intensificação das desigualdades?

EUBANKS: Uma das coisas que é interessante até nas inteligências artificiais com processos de aprendizado mais sofisticados é que elas só podem aprender por meio de dados que elas já têm. E essa é uma das coisas que nós constantemente esquecemos quando falamos sobre esses sistemas preditivos. Parece bem óbvio, mas acho que não falamos o suficiente sobre isso. Os sistemas só podem realmente fazer decisões baseadas em padrões do passado, e, por serem baseados em padrões do passado, eles são baseados em nosso histórico de desigualdades de raça, gênero e classe. Então, deixe-me te dar um exemplo concreto. Eu conto três histórias no livro e uma delas é sobre um modelo de estatísticas chamado The Allegheny Family Screening Tool, no Condado de Allegheny, na Pensilvânia, que fica em Pittsburgh. E o modelo é construído baseado em um servidor de dados que foi criado em 1999, que coleta dados de 29 programas estatais e de condados. São coisas como probatório para jovens e adultos, autoridades imobiliárias, serviços de álcool e drogas, os escritórios de compensação implementada, coisas deste tipo. E o modelo que é construído em cima desse servidor de dados é um modelo que supostamente deve prever quais crianças talvez venham a ser vítimas de abuso ou descaso em algum momento futuro. O que é um objetivo louvável, certo? Digo, crianças podem realmente estar vulneráveis a essas coisas, e eu acredito que o Estado tenha obrigação e direito de intervir em casos onde crianças possam ser prejudicadas. Mas o problema com essa ferramenta é pelo Gabinete do Condado só ter acesso a dados que o Condado coleta, que, no caso dos Estados Unidos é, realmente, apenas dados sobre famílias pobres e da classe trabalhadora, então ela pode somente enxergar e prever o tipo de dano que talvez aconteça em famílias pobres e da classe trabalhadora. E esse é um problema tanto por questão de falsos positivos quanto de falsos negativos. Então, os falsos positivos veem danos onde provavelmente não existe, e pais no Condado de Allegheny que já se envolveram com os Serviços de Proteção Infantil, por exemplo, se preocupam bastante com os falsos positivos. O motivo é que muitos dados sobre suas famílias são coletados, de maneira que essas ferramentas acabam hiper-identificando danos potenciais em suas comunidades, e isso gera um ciclo vicioso, onde, por já estarem sob vigilância, há mais dados sobre eles, e, por que há mais dados sobre eles, eles são identificados com mais potencial de risco e, pelo sistema enxergá-los como mais perigosos, coleta mais dados sobre eles; e então é fechado esse ciclo vicioso de feedbacks injustos. Falso negativo é não enxergar danos onde danos possam de fato existir. Portanto, como o sistema não coleta informações sobre famílias de elite econômica, não é capaz de identificar os tipos de danos que podem estar acontecendo nessas famílias. Então, por exemplo, os trabalhadores com os quais conversei dentro do sistema de Escritórios de Serviços para crianças, jovens e famílias do condado de Allegheny disseram que estavam realmente preocupados com esse problema de falsos negativos. Como eles estavam apenas coletando informações sobre famílias pobres e da classe trabalhadora em Pittsburgh, você não seria capaz de ver o tipo de dano que acontece, por exemplo, quando uma família está geograficamente isolada. E existem evidências bem concretas de que o isolamento geográfico aumenta a possibilidade de abuso ou negligência, mas você não obterá informações sobre essas famílias no sistema porque as pessoas das quais eles estão coletando dados vivem nos bairros centrais da cidade de Pittsburgh, não nos subúrbios. Portanto, esses sistemas preditivos baseados em estatísticas só podem realmente entender os padrões do passado, eles são absolutamente moldados pelas decisões que tomamos no passado sobre como e de quem devemos coletar dados, quem é arriscado e quem é perigoso para sua família – e nos Estados Unidos isso tem tudo a ver com raça e classe, então é assim que a desigualdade é incorporada a esses sistemas e, como esses sistemas são tão rápidos e eficazes, acabam ampliando e intensificando as desigualdades.

DIGILABOUR: Como tratar as noções de classe e classe trabalhadora em contexto de desigualdades automatizadas?

EUBANKS: Essa é uma daquelas conversas que podem ser difíceis transculturalmente, porque os EUA, em minha opinião, são realmente únicos na absoluta recusa e incapacidade de reconhecer as desigualdades de classe e econômicas, o que torna muito difícil falar sobre isso. Portanto, na verdade, não temos nos EUA uma linguagem boa para falar sobre classe, o que cria problemas únicos para a realização de pesquisas sobre injustiças econômicas. Então, há muito trabalho realmente bom por aí sobre discriminação algorítmica, que se concentra na raça, por exemplo, que é um trabalho incrivelmente importante e crucial. Ruha Benjamin fez alguns trabalhos sobre isso, Safiya Noble igualmente, e estou realmente empolgada em ver esse trabalho, principalmente no campo da justiça criminal. Mas existem algumas coisas que são específicas em relação a ser uma pessoa pobre da classe trabalhadora nos EUA, e isso é verdade para brancos pobres, afro-americanos pobres, latino-americanos pobres. O que é específico no contexto dos EUA é a interação das pessoas com esses programas públicos, que são a nossa esperança e, às vezes, o mito nacional que contamos a nós mesmos: de que seriam programas amplamente generosos, até demais. Uma das maneiras que falamos sobre eles nos EUA, os programas de assistência social especificamente, é como se fossem um desperdício, e direcionados a pessoas que estariam envolvidas em fraudes, pedindo coisas que realmente não precisam. E isso está fundamentado, novamente, neste momento da História que remonta aos anos 1800 e 1900, e nas poorhouses dos condados. Portanto, parte do argumento que faço no livro é a idéia de que, se você ousar pedir apoio público, renuncia a vários outros direitos: direito à privacidade, direito à união familiar, para manter seus filhos com você, seu direito a necessidades básicas, como moradia, alimentação e assistência médica. Essa ideia de que você troca seu direito político por seu direito econômico é realmente perigosa, e você a vê expressa nos sistemas de tecnologia, na maneira que tratamos essas ferramentas como um meio de triagem digital. Conversei com muitos designers diferentes, com muitos tipos diferentes de pessoas que estavam construindo esses sistemas quando eu estava fazendo pesquisas para o livro. Eles tinham muitas opiniões diferentes sobre como essas ferramentas deveriam funcionar e para que servem, mas uma coisa que todos eles tinham em comum é que todos se referiam a essas ferramentas como de “triagem digital” para decidir quem dentre as milhões de pessoas pobres e da classe trabalhadora nos EUA merece acesso a recursos realmente limitados. Então, a ideia era que essa ferramenta os ajudaria a tomar decisões bem difíceis, classificando as pessoas com base em seus merecimentos a apoio ou ajuda. E um dos argumentos que faço no livro é que estamos empregando de maneira errônea o termo triagem; na verdade, “triagem” só é realmente apropriado se você estiver no meio de uma crise com tempo limitado e se houver mais recursos por vir. Se não houver mais recursos chegando e se você estiver no meio de uma crise persistente ou infinita, na verdade, não é uma triagem que você está fazendo, é um racionamento digital. E eu acho que é realmente importante deixar claro que essa escolha de fazer triagem, por si só, de dizer que existe uma maneira de classificar as pessoas em termos de elas poderem ou não acessar seus direitos humanos básicos. Isso é uma escolha política. Não é uma escolha técnica. Não é uma escolha baseada em um universo de recursos limitados. É uma escolha política que diz basicamente que não acreditamos que todo ser humano mereça acessar seus direitos humanos básicos, como comida, abrigo e segurança.

DIGILABOUR: Como desmantelar a digital poorhouse?

EUBANKS: Eu sempre peço desculpas quando chegam perguntas como essa, mas não farei isso com você, porque acho que a pesquisa realmente precisa acontecer em vários níveis ao mesmo tempo. É realmente um trabalho árduo e de longo prazo. Então, no contexto dos EUA, pelo menos, eu sinto que o trabalho tem que acontecer em pelo menos três lugares ao mesmo tempo, um é na mudança cultural, acerca de como falamos sobre pobreza. Nos EUA temos uma ideia totalmente incorreta de que a pobreza é uma aberração em nosso sistema e que ocorre apenas a uma pequena proporção, a uma minoria minúscula de pessoas provavelmente patológicas. A realidade é que, ao longo de nossas vidas, 51% dos americanos estarão abaixo da linha da pobreza em algum momento entre as idades de 20 e 64 anos. E um total de dois terços de nós dependerá de programas públicos, o que está diretamente ligado às políticas de bem-estar público. Então, embora existam muitas coisas que afetam sua vulnerabilidade à pobreza e o que acontece quando você fica abaixo dessa linha, esse é um problema majoritário nos EUA. A maioria de nós será pobre em algum momento de nossa vida, e não é dessa maneira que falamos sobre a pobreza no país. Então, acredito que, se pudermos encontrar a coragem de contar a verdade uns pros outros sobre nossas experiências em uma espécie de fronteira de pobreza ou escassez econômica, poderemos então mudar essa narrativa que diz que há algo de errado nas pessoas que acabam sendo pobres. É como dizer que há algo errado com as pessoas que acabam engravidando. Não é uma doença, não é um problema, é uma condição. Acontece com a maioria das pessoas. Se fizermos esse trabalho cultural, acredito que seremos capazes de realizar uma segunda parte de trabalho realmente importante, que é o trabalho político, e precisamos mudar nossos sistemas de suporte público, de sistemas que são baseados nas ideias que a primeira coisa que precisamos fazer é construir termômetros morais. Precisamos construir equipamentos de diagnóstico para descobrir o que há de errado com você, por você ser pobre. Em vez disso, precisamos construir apoios universais, pisos universais para todos, baseados, acredito, em idéias de direitos humanos econômicos. E, nesse meio tempo, enquanto trabalhamos nisso, a tecnologia não vai simplesmente parar e estalar seus dedos e esperar que descubramos o que faremos a seguir (risos). E então, ao mesmo tempo, acho que também precisamos descobrir maneiras de construir tecnologias menos prejudiciais. Eu tenho no livro uma hipótese para criar uma tecnologia que causa menos danos, mas que realmente se resume a duas perguntas básicas que os designers deveriam se fazer. A primeira é: a ferramenta aumenta a autonomia e a dignidade das pessoas pobres e da classe trabalhadora? A segunda é: se essa ferramenta visasse, focalizasse, qualquer outro grupo de pessoas, além de mais pessoas da classe trabalhadora, sua existência sequer seria tolerada? E, pelo menos nos casos que analiso no livro, nenhuma das ferramentas que estudei durante a pesquisa realmente se adequam, nem a esse padrão bastante patético. E acredito que podemos fazer melhor, acredito que merecemos melhor, então temos que construir esses sistemas não visando o mundo que poderíamos ter um dia, o que desejávamos habitar, mas o mundo no qual realmente vivemos. Isso significa reconhecer que vivemos em um mundo em que nossas instituições estão entrelaçadas, com profundas amarrações, na criação de desigualdades. Portanto, temos que construir essas ferramentas com todos os nossos valores, intencionalmente, desde o começo. E não quero dizer apenas eficiência, não é apenas economia de custos, ou mesmo apenas justiça, são valores gerais, coisas como autodeterminação, dignidade, autonomia, honestidade e justiça. E precisamos fazer isso desde o início, e em cada ferramenta: em vez de construí-las para serem neutras e objetivas, precisamos construí-las explicitamente para fazer justiça.

Digital Poorhouse

Automatização dos serviços públicos e intensificação das desigualdades

Noções de classe e classe trabalhadora em contexto de desigualdades automatizadas

Como desmantelar o digital poorhouse?